本文转载自:量子位(QbitAI)

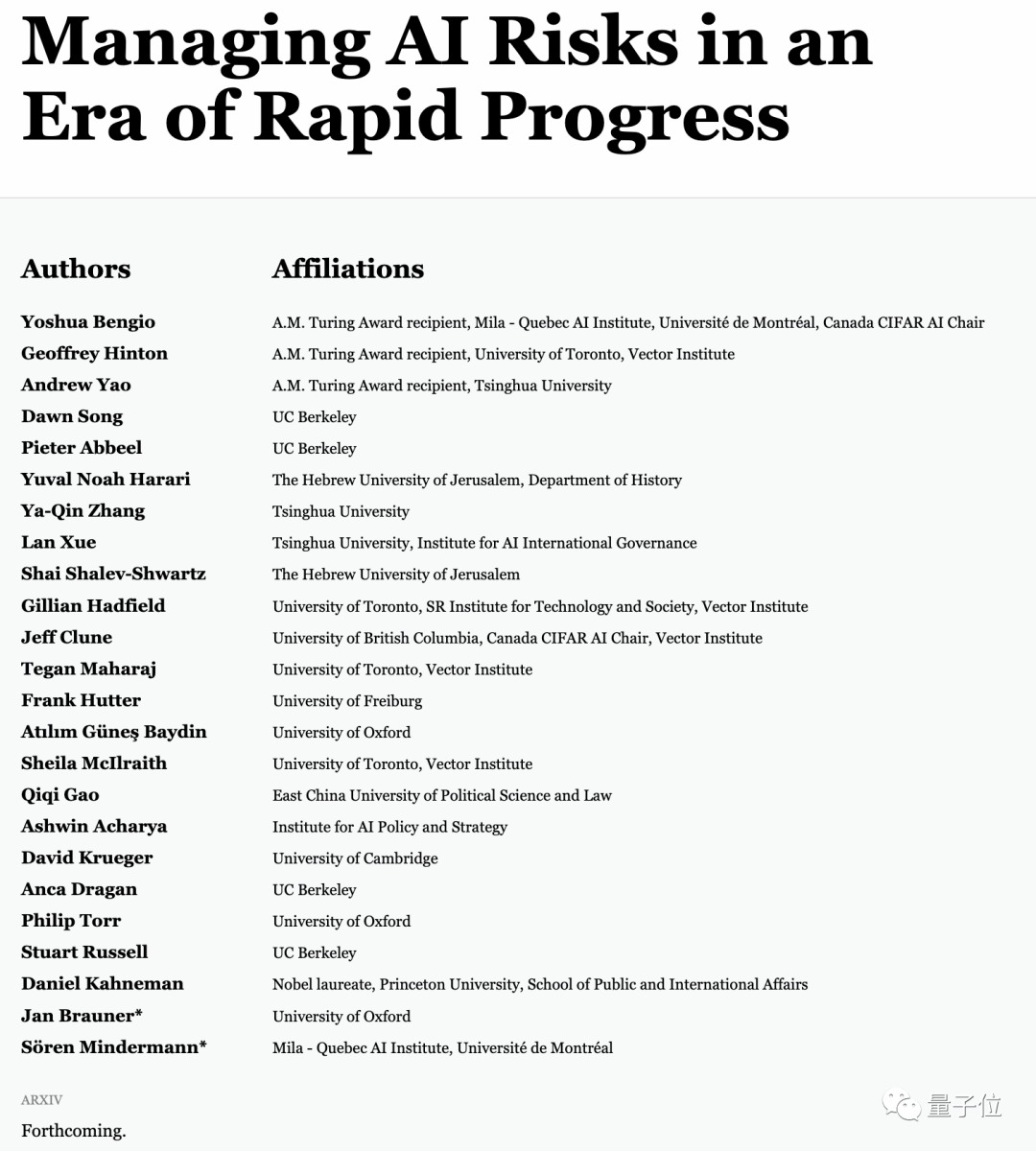

三位图灵奖得主Hinton、Bengio、姚期智,联名发文《在快速发展的时代管理AI风险》。

还有UC伯克利宋晓东、Pieter Abbeel,清华张亚勤等更多知名学者合著。

这是一篇共识论文(consensus paper),除AI研究者外,还有公共治理方面的学者,如清华大学人工智能国际治理研究院薛澜,以及诺贝尔经济学奖得主丹尼尔卡尼曼等。

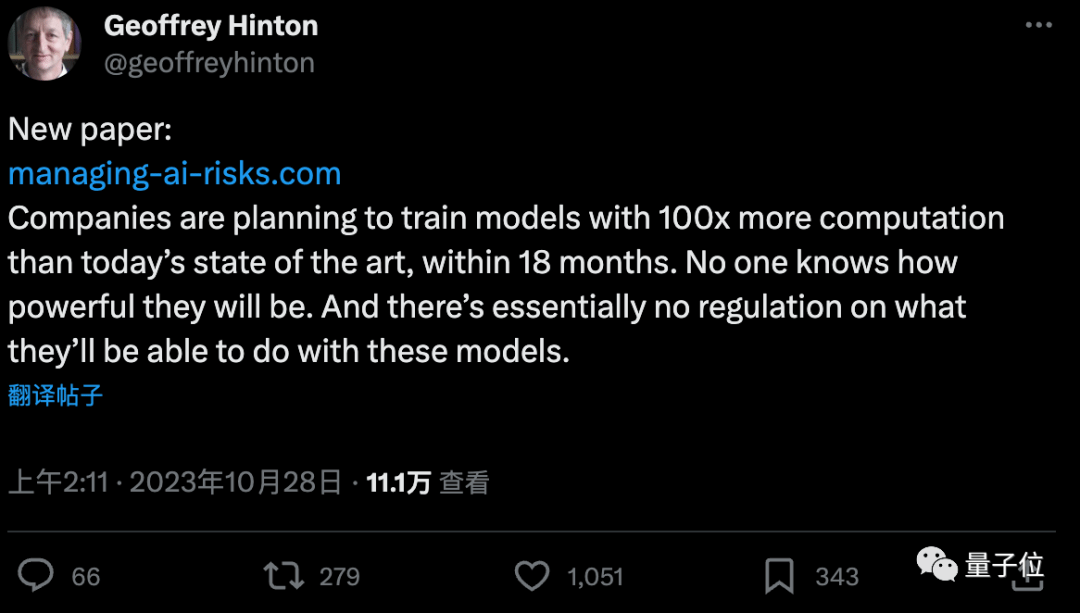

Hinton认为,公司们正计划在18个月内把AI模型计算规模扩大100倍,没人知道这些模型会有多强大,也没有关于他们如何使用这些模型的规定。

(18个月100倍的计划来自InflectionAI)

目前论文公布在独立域名站点managing-ai-risks.com,arXiv版本将在稍后上传。

正文翻译

回顾2019年,GPT-2还不能完美地数数。

而在短短四年之内,深度学习技术已可助力开发软件、创造逼真的虚拟环境、提供专业的建议,并且让机器人具备了语言理解能力。

这些系统的进步不断超越预期,令人瞠目结舌。

而接下来的进展或许会更为惊人。

尽管现有的深度学习系统尚有不少局限,但各大公司已在争相研发能与人类智慧抗衡的通用AI。他们投入的资源越来越多,创新的技术日新月异,且AI的自我进化能力加速了这一趋势。

没有迹象显示AI的进步会在达到人类智慧的水平后停滞。

事实上,在某些特定领域,AI已经超越了人类。它们可以更快地学习、处理更多的信息,且在大规模计算中表现出色,而且可以轻松复制。

技术的飞速进展令人震撼。一些科技巨头有能力将其AI训练规模在短时间内增加数倍。考虑到AI研发的持续投入和自我进化的趋势,通用AI在未来十到二十年内超越人类的可能性不容忽视。

若被正确和公正地应用,先进的AI可以为人类解决长久以来的问题,如疾病、贫困和环境问题。但与此同时,强大的AI也带来了巨大的风险,这些风险我们还远未准备好应对。我们需要平衡AI的能力与安全性。

遗憾的是,我们在调整策略方面已经稍显落后。我们需要提前预见并应对风险,不能等到问题真正出现时再行动。环境问题就是一个例证,但AI发展的速度意味着我们没有太多时间可等。

AI的高速进步对社会带来了巨大的挑战。若不加以管理,它们可能加剧社会不平等、威胁社会稳定并削弱我们对真实世界的认知。它们甚至可能被用作犯罪工具,或者加剧全球的不平等和冲突。

更令人担忧的是,自主AI的发展可能会放大这些风险。当前的AI虽然尚不完全自主,但这一状态正在发生改变。例如,GPT-4尽管强大,但如果控制了具有自主目标追求的机器人或程序,其行为可能变得难以预测,且我们可能难以干预。

为此,我们呼吁全球共同努力,通过技术、政策和法律手段来规范自主AI的发展和应用。否则,我们可能会面临一个被AI主宰和误用的未来。

这只是开始。我们急切需要更多的研究和讨论来解决这些问题,并希望得到社区的支持和协助,以确保AI为人类带来真正的好处,而非威胁。

参考链接:

[1] managing-ai-risks.com

[2] https://twitter.com/geoffreyhinton/status/1717967329202491707