哈尔滨工业大学长聘教授,主要研究方向为人工智能、自然语言处理、大语言模型和社会计算

刘挺

(哈尔滨工业大学 计算学部社会计算与信息检索研究中心 黑龙江 哈尔滨 150001)

互联网、物联网、大数据的迅猛发展使信息空间得以与物质空间、精神空间并列,构成三元空间。人工智能技术在信息空间里对海量数据进行加工处理,其结果反过来作用于物质空间和精神空间。大语言模型(以下简称“大模型”)出现后,机器可以自动生成数据,这些数据真真假假,既丰富了信息空间,也污染了信息空间,其对三元世界所构成的影响难以估量。

人工智能经历了4次高潮。第三次高潮是2010年前后由深度学习推动的。2022年11月,OpenAI发布由大模型支持的ChatGPT–3.5,标志着人工智能第四次高潮的到来。

大模型所属的学术方向是人工智能下的自然语言处理,GPT(生成式预训练转换器)在GPT–3及以前都是自然语言处理业内关注的技术,而以GPT–3.5为基础的ChatGPT则因为惊人的人机对话能力而出圈,受到世界范围内各个行业的追捧。

GPT是语言的生成模型,简单地说就是根据上文预测下一个“词”,如此往复不断地生成下一个词,就连词成句,连句成篇,超预期地回答出用户的问题。

为什么GPT能够产生这样的突破性进展呢?关键的奥秘在于:通过挖词构造带有标准答案的填空题,毫无成本地产生无限量的训练数据,让机器在努力学习解答填空题的过程中获得通用的语言智能。这种机器学习方式既有别于有监督学习——因为不需要人工标注数据,又有别于无监督学习——因为有标准答案,兼具有标准答案和无人工成本的优点,被称为自监督学习。

此外,用低维、连续、稠密的向量而不是符号表达语义也是大模型取得突破的重要原因。传统上我们把词视为符号,但符号与符号是孤立的,需要额外建立知识库去定义符号之间的关系,而词向量则是根据“观其伴知其义”的原则自动从海量文本数据中计算得来,根据词向量可以判断“桌子”和“板凳”的语义距离,比“桌子”和“西红柿”的语义距离更近,据此叠加推演,可以计算句子语义、篇章语义。

当然,大数据和高算力也是重要原因。ChatGPT内部有1750亿参数,其量级比人类大脑神经元的数量还高出一个数量级。量变产生质变,“涌现”现象出现了。此外,指令精调、人类反馈强化学习等也都是助推ChatGPT取得革命性突破的原因。

大模型能够很好地回答用户的问题,有些答案比人回答的更好。从问答的角度,可以把大模型与数据库、搜索引擎进行对比。数据库以结构化的方式(比如二维表)存储信息,用标准的查询语言(比如SQL)进行访问,用户访问数据库的方式是不自然的。搜索引擎以非结构化的方式存储数据(比如网页、视频等),用户可以比较自由地用关键词表达自己的搜索请求,但表达仍然是不充分不自然的,检索结果是未经加工的原始信息。大模型将其收集到的全部信息以参数化的方式存储,允许用户用人们最熟悉的自然语言语句自由充分地表达其对信息的需求,大模型理解用户的意图并基于模型内部复杂的参数系统全新地生成段落、篇章作为答案。由于答案是机器针对用户的特定提问自动编写出来的,而不是找出来的,因此是能够充分满足用户特定信息需求的,但同时也存在出现“幻觉”的风险。

总的来说,ChatGPT本质上是一个由1750亿个浮点数参数表示的深度神经网络大模型,是一个对话式AI系统,它首次实现了语言智能的智慧涌现,在海量信息的全量在线记忆、任意任务的对话式理解、复杂逻辑的思维链推理、多角色多风格长文本生成和即时新知学习与进化等5个方面取得了重大突破。

从解决语言问题的不同层面,可以把自然语言处理的发展分为4个阶段:形式、语义、推理和语用。传统的搜索引擎解决了形式匹配的问题,但是,要用不同形式表达相同的含义,就需要语义分析了,比如在电信客服场景下,“请查一下我的话费余额”(标准问法)和“我还剩多少钱了”(口语问法)就是一个含义,这是形式匹配所无法解决的。语言中的深层含义是字面上无法获知的,比如用户评论“这家五星级宾馆,没有游泳池”,其情感倾向是负面的,这需要基于“五星级宾馆一般有游泳池”这条知识进行推理才能得出结论。自然语言处理的最高境界是理解文字背后的弦外之音,比如“他可了不起了”,是不是真心夸赞,需要充分了解上下文背景才能确定。

笔者编了一句话,问ChatGPT:“‘想来想去,只有一种职业不会受到ChatGPT的威胁——无业游民。’这句话什么含义?”ChatGPT回答:“这句话有些讽刺意味,暗示了人工智能的发展可能导致一些人失去工作,而无业游民却不受其影响。”ChatGPT已经能够理解讽刺,说明在大模型的推动下,自然语言处理处于从“推理”向“语用”迈进的阶段。

从自然语言处理的研究范式来看,1950~1990年占主导地位的是小规模专家知识,1990~2010年是浅层机器学习,2010~2017是深度学习,2019~2022是预训练语言模型,2023年开始进入大模型时代。进入深度学习阶段,不再需要人工的特征工程了;进入预训练模型时期,大规模的数据不需要人工标注了;进入大模型时代,各种语言处理任务均统一为生成任务。

大模型时代,自然语言处理诸多任务(问答、翻译、文本生成、信息抽取等)的边界被打破了,一个大模型能够胜任诸多任务,还能较好地处理未曾见过的新任务。原来“丛林式”的自然语言处理研究格局,瞬间演变为“大树式”的模式,树根是“大模型”,树干很矮,包含多项特定任务,枝叶茂密,深入到千行百业,是大模型的应用。

ChatGPT不但打破了自然语言处理研究的格局,而且将对社会产生深刻影响。2023年3月,《人类简史》作者尤瓦尔·赫拉利接受《三联生活周刊》采访,他说:“人类文化基于语言。而因为人工智能已经破解了语言,它现在可以开始创造文化。……人类将开始适应由非人类实体创造的文化。而且,由于文化是人类的‘操作系统’,这意味着人工智能将能够改变人类思考、感受和行为的方式。”埃隆·马斯克认为,ChatGPT好得吓人,我们离危险的强人工智能不远了。美国作家、Robust. AI公司创始人加里·马库斯也说,生成式人工智能将对社会结构产生切实的、迫在眉睫的威胁。

大模型并非绝对完美,围绕对大模型的改进还有很多研究工作要做,主要包括弥补大模型的不足,推广大模型的应用,探究大模型的机理等3个方面。

大模型的不足存在于多个方面:(1)事实一致性不足,时常出现“幻觉”。从本质上讲,大模型不是在查找信息,而是把海量数据变成了参数,再重新生成文本。在生成的过程中就会有编造“事实”的可能性。(2)逻辑一致性的不足。在多轮对话中,大模型时而失去对人和事物内在逻辑的把控。(3)需要的数据量和算力资源过大,导致训练和应用过程耗资巨大,大多数研究机构和企业都无法承受。余不细述。

为了弥补大模型的不足,未来一段时期,以下问题亟待研究:如何提高生产文本的可信性;如何对机器人进行角色化,让机器生产的话语符合特定角色的身份、性格特点和语言风格;如何让机器更懂某个特定用户,并提供个性化的服务;如何在一些严肃领域(比如医疗)打破数据孤岛,使用私有数据进行训练;如何对模型进行裁剪或压缩,使得模型趋于小型化,以便于应用;如何从多模态数据(图像、视频、语音等)获取更丰富的信息;如何通过数据拆分与重组、工程优化和P2P训练等手段提升训练效率;如何通过算力网把分散在多地的算力资源统一使用起来;等等。

在通用大模型的基础上,如何与各个行业、各个场景结合,利用领域大数据训练出行业大模型,是多数科研机构和企业未来的工作重点。行业有两大类:一类是人与数据互动比较多的行业,如教育、医疗、金融等,这些行业里有丰富的场景需要人的参与,大模型可以直接派上用场;另一类是物与数据互动比较多的行业,比如制造业、电力、农业、交通等行业,在这些行业,大模型只能对行业知识的挖掘、问答发挥作用,而对行业中的生产、流通过程如何发挥作用尚需探索。大模型的效果的确大幅度地超越了以往的自然语言处理技术,但能否满足严肃场景(如医疗、法律、军事等)下人类使用者的要求,能否突破最后一公里,真正落地,为行业带来价值,仍然有待观察与实践。

人类历史上各种发明创造都是在弄清了原理的情况下产生的,但大模型是一个例外。智慧涌现了,这是事实,但包括ChatGPT的发明人在内,谁都没能准确地解释大模型的机理。通过全方位的评测去探索大模型的内在机理,是未来一段时期的重要研究课题。

ChatGPT能够自动回答人们的问题,当人们对ChatGPT产生依赖时,ChatGPT的观点就会对用户的认知产生影响,从而带来认知安全上的挑战。

认知是指人们获得知识或应用知识的过程,或信息加工的过程,这是人的最基本的心理过程,它包括感觉、知觉、记忆、思维、想象和语言等。认知安全是指人的意志、信念、思维、心理等精神因素的安全。

认知安全包括诸多层面,如知识、心理、道德(价值观)、法律、政治等。例如,知识错误,或者陈述不符合事实;认知扭曲,说出的话走极端或者非常情绪化;观点不符合主流价值观,或者与当时当地的文化习俗相背离;用户的提问或机器的答复违背法律法规;内容反动,危害国家安全。凡此种种,均可视为有害信息,对中国公众的认知安全构成威胁。

党的二十大报告强调“打造强大战略威慑力量体系,增加新域新质作战力量比重,加快无人智能作战力量发展,统筹网络信息体系建设运用”。网络战、舆论战就是典型的新域新质作战,与传统的陆海空天战争形态相比,是悄无声息、没有硝烟的战场,也是在和平年代却每时每刻都在进行的战斗。而舆论战与网络战又不同,其战斗不是发生在“外在的信息层面”,而是通过信息空间在“内在的意识层面”进行斗争,其隐蔽性、渗透性更强。舆论战中,语言成为武器,而今的大模型能够自动回答问题,发表评论,撰写文章,使语言武器自动化了,其带来的风险难以估量。

为了维护中国公民的认知安全,迫切需要加强对有害信息的自动识别、自动反驳与纠正技术的研究。如果是国产大模型,则还要对模型进行内容安全性的自我过滤,避免由于训练数据中存在不良信息或模型的“幻觉”,导致输出有害信息。

大模型是建立在语言大数据基础上的,语言大数据不只是语言符号串的集合,更是人类知识、经验的宝库。如同一个民族的基因大数据是这个民族的生物遗传密码一样,一个民族的语言大数据包含着这个民族的思想密码、文化密码、历史密码。即时的语言大数据还包含着当前社会的政治经济动态,对一个国家而言是非常宝贵的财富。

真正高质量的语言数据并非都是能够在互联网上随意抓取的,它们蕴藏在各个部门、各个企事业单位的私有数据库中,对这些数据的保护应该像对基因数据的保护一样,引起我们的高度重视。同时,在研发国有通用大模型的过程中,又需要把散落在各处的高质量语言大数据集中起来使用,确保中国自有的中文大模型在世界上的领先地位。

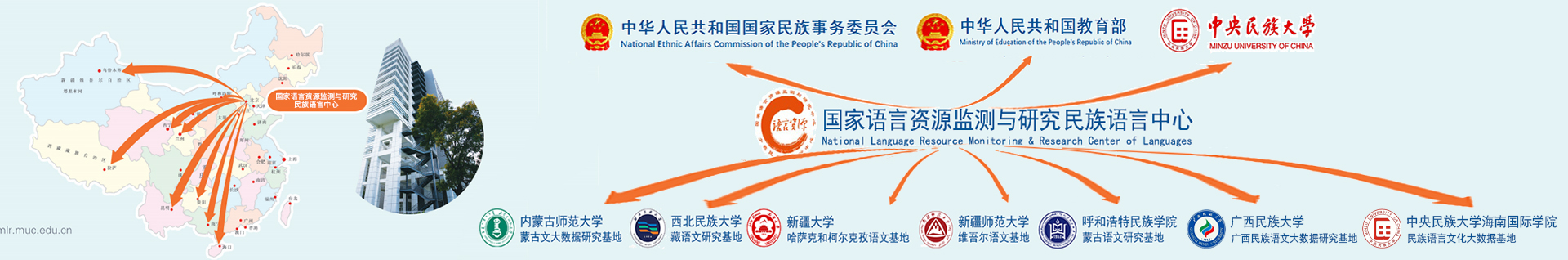

同时,大模型是没有语种边界的,为了争夺国际话语权,为了进一步拓展国际经贸往来,中国也需要有意识地采集、保存、整理海量的多语种数据资源,既包括世界主要语言,也包括小语种。各国各民族的语言大数据蕴含着各自的文化、历史和当前的政治经济状况,对于我们研究区域国别学至关重要,对于构建中国强大的多语种大模型至关重要。

当前,人们正在试图通过算力网络把散布在各地的算力集中调配,同样,散布在各地的语言大数据能够通过标准制定,通过对语言大数据的评估、定价,促进共享、交易,使国内的语言大数据被国内大模型研发机构充分使用,发挥出语言数据作为新的生成要素的重要作用,也值得有关人士深入探讨。

大模型能够生成非常连贯而有逻辑性的语篇,其对语言自身规律的掌握已经达到甚至超过普通人的水平。但是,对语言所负载的知识、经验,尤其是道德、文化、价值观等的把握,大模型还需要向人学习。因此,未来的语言资源加工,更多的不是对语言自身词法句法语义结构的标注,而是对语言所负载的信息的人工标注,在ChatGPT的研制过程中,包括“提示Prompt”的构造,包括人类反馈强化学习(RLHF)等都有人的充分参与,值得我们借鉴。

ChatGPT横空出世,其惊艳的问答效果,把自然语言处理的水平拉到了一个远超预期的高度,不但让AI业内人士惊讶地看到了通用人工智能的曙光,也让千行百业看到了通用人工智能可能给自己所在行业带来的重大机遇与挑战。ChatGPT的出现引起我们的深刻反思:到底什么是语言?语言相关的工作者(包括语言学家和自然语言处理专家)未来的努力方向在哪里?为什么中国没有率先发明出大模型来?

虽然还有诸多困惑,但大模型时代已经来临,我们必须擦亮眼睛,直面现实,总体规划布局,充分交叉协作,在保证数据安全、认知安全的前提下,大力研制国产大模型,并推动其各行业落实,为中国的经济发展、社会繁荣作出贡献。